上个月,英伟达宣布了一个名为 Maxine 的新平台,该平台使用人工智能来增强视频会议软件的性能和功能。该软件使用神经网络来创建一个人脸的紧凑表示。然后可以通过网络发送这种紧凑的表示,其中第二个神经网络重建原始图像 - 可能进行有用的修改。

英伟达表示,与传统压缩技术相比,其技术可以将视频会议软件的带宽需求降低 10 倍。它还可以改变人脸的显示方式。例如,如果某人由于相机的位置而看起来偏离中心,则该软件可以旋转她的脸以使其直视。软件还可以用动画化身替换某人的真实面孔。

Maxine 是一个软件开发工具包,而不是一个消费产品。Nvidia 希望第三方软件开发商能够使用 Maxine 来改进他们自己的视频会议软件。该软件有一个重要的限制:接收视频流的设备需要具有张量核心技术的 Nvidia GPU。为了支持没有合适显卡的设备,Nvidia 建议在云中生成视频帧——这种方法在实践中可能行得通,也可能行不通。

但不管 Maxine 在市场上的表现如何,这个概念似乎对未来的视频流服务很重要。不久之后,大多数计算设备将强大到足以使用神经网络生成实时视频内容。Maxine 和类似的产品可以以更低的带宽消耗提供更高质量的视频流。

决斗神经网络

Maxine 建立在称为生成对抗网络 (GAN) 的机器学习技术之上。

GAN 是一个神经网络——一个复杂的数学函数,它接受数值输入并产生数值输出。对于视觉应用,神经网络的输入通常是图像的逐像素表示。例如,一个著名的神经网络将图像作为输入,并输出图像落入“达尔马提亚”和“蘑菇”等 1000 个类别中的每一个类别的估计概率。

神经网络有数千个——通常是数百万个——可调参数。该网络是通过根据真实世界数据评估其性能来训练的。该网络显示了一个真实世界的输入(如狗的图片),其正确分类为训练软件所知(可能是“达尔马提亚狗”)。然后训练软件使用一种称为反向传播的技术来优化网络参数。将网络推向正确答案的值会得到提升,而导致错误答案的值会被回拨。在对数千甚至数百万个示例重复此过程后,网络可能会非常有效地完成其正在接受的训练任务。

进一步阅读

神经网络是如何工作的——以及它们为何成为一门大企业

训练软件需要知道每个输入的正确答案。出于这个原因,经典的机器学习项目通常需要人们手动标记数千个示例。但是,如果有一种方法可以自动生成训练数据,则可以大大加快训练过程。

生成对抗网络是一种无需人工标记训练数据即可训练神经网络的巧妙方法。顾名思义,GAN 实际上是两个相互“竞争”的网络。

第一个网络是一个生成器,它将随机数据作为输入并尝试生成逼真的图像。第二个网络是一个鉴别器,它获取图像并尝试确定它是真实图像还是第一个网络创建的伪造图像。

训练软件同时运行这两个网络,每个网络的结果用于训练另一个:

鉴别器的答案用于训练生成器。当鉴别器错误地将生成器创建的照片归类为真实照片时,这意味着生成器在创建逼真的图像方面做得很好——因此导致该结果的参数得到加强。另一方面,如果鉴别器将图像分类为伪造,则将其视为生成器的失败。

同时,训练软件向鉴别器显示随机选择的图像,这些图像要么是真实的,要么是由生成器创建的。如果鉴别器猜对了,那就被视为成功,鉴别器网络的参数会更新以反映这一点。

在训练开始时,两个网络都不擅长他们的工作,但随着时间的推移它们会有所改善。随着生成器图像质量的提高,鉴别器必须变得更加复杂以检测假货。随着鉴别器的鉴别力越来越强,生成网络得到训练,使照片看起来越来越逼真。

结果可能非常壮观。一个名为ThisPersonDoesNotExist.com的网站 完全符合它的要求:它生成了不存在的人类的真实照片。

该网站由一个名为StyleGAN的生成神经网络提供支持,该网络由 Nvidia 的研究人员开发。在过去十年中,由于 Nvidia 的显卡已成为最流行的神经网络计算方式之一,Nvidia 在神经网络技术的学术研究上投入了大量资金。

GAN 的应用激增

最早的 GAN 只是试图在像人脸这样的广泛类别中生成随机逼真的图像。这些被称为无条件 GAN。最近,研究人员开发了条件 GAN——神经网络,它获取图像(或其他输入数据),然后尝试生成相应的输出图像。

在某些情况下,训练算法向生成器和鉴别器提供相同的输入信息。在其他情况下,生成器的损失函数(衡量网络在训练方面表现的好坏的度量)将鉴别器的输出与其他一些判断输出与输入数据拟合程度的指标相结合。

这种方法具有广泛的应用。研究人员使用条件 GAN从文本描述生成艺术作品,从草图生成照片,从卫星图像生成地图, 预测人们长大后的样子等等。

这让我们回到了 Nvidia Maxine。Nvidia 尚未提供有关该技术如何运作的完整细节,但它确实向我们指出了2019 年的一篇论文,该论文描述了支持 Maxine 的一些底层算法。

该论文描述了一个条件 GAN,它将一个人的面部谈话视频和第二个人的几张照片作为输入。生成器创建第二个人的视频,该视频的动作与原始视频中的人相同。

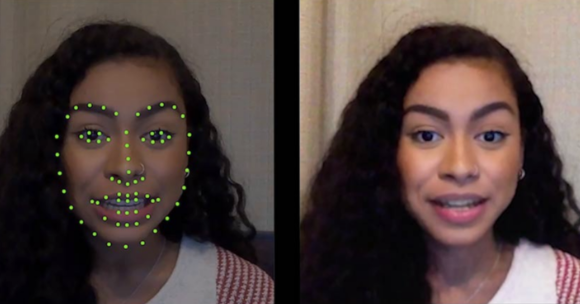

Nvidia 的新视频会议软件对这种技术稍作修改。Maxine 不是将视频作为输入,而是采用从源视频中提取的一组关键点——数据点指定了对象的眼睛、嘴巴、鼻子、眉毛和其他面部特征的位置和形状。与普通视频相比,这些数据可以更紧凑地表示,这意味着它可以通过网络传输,占用的带宽最少。网络还发送高分辨率视频帧,以便接收者知道主题的外观。然后接收者的计算机使用条件 GAN 来重建对象的面部。

Nvidia 研究人员在 2019 年描述的网络的一个关键特征是它不是特定于一张脸。可以训练单个网络以根据作为输入提供的照片生成不同人的视频。Maxine 的实际好处是无需为每个用户训练新网络。相反,英伟达可以提供一个可以绘制任何人脸的预训练生成器网络。与从头开始训练新网络相比,使用预先训练好的网络需要的计算能力要少得多。

Nvidia 的方法使以多种有用的方式操作输出视频变得容易。例如,视频会议技术的一个常见问题是摄像头偏离屏幕中心,导致一个人看起来在看一边。Nvidia 的神经网络可以通过旋转用户面部的关键点使其居中来解决这个问题。英伟达并不是第一家这样做的公司。苹果一直工作在它自己的版本此功能的FaceTime。但英伟达基于 GAN 的方法可能会更强大,允许修改整个面部而不仅仅是眼睛。

Nvidia Maxine 还可以用执行相同动作的动画角色替换对象的真实头部。同样,这并不新鲜——几年前 Snapchat 普及了这个概念,它在视频聊天应用程序中变得很普遍。但英伟达基于 GAN 的方法可以实现更逼真的图像,在更广泛的头部位置上工作。

标签:

免责声明:本文由用户上传,与本网站立场无关。财经信息仅供读者参考,并不构成投资建议。投资者据此操作,风险自担。 如有侵权请联系删除!